在《自然》杂志最新发表的研究论文中,揭示了人工智能(AI)面临的一个严峻挑战:使用由AI生成的数据集来训练后续世代的机器模型,可能导致其输出结果严重扭曲,这一现象被称作“模型崩溃”。

研究显示,在经过九次迭代后,原本的内容会变成无关的乱码(例如,一篇关于建筑的文本最终演变成一系列野兔的名字)。

这一发现凸显了采用可靠数据训练AI模型的重要性。

目前,诸如大型语言模型等生成性AI工具越来越受到欢迎,这类工具主要依靠人类产生的输入进行训练。

然而,随着这些模型在互联网上的不断扩散,计算机生成的内容可能会以递归的方式用于训练其他AI模型或其自身。

包括英国牛津大学在内的研究团队一直在对此进行研究,并在之前的预印本论文中提出了相关概念。

他们在正式发表的论文中使用数学模型展示了潜在的AI“模型崩溃”问题。

研究团队分析了当AI模型处理主要由AI生成的数据集时的行为模式,并发现向模型输入AI产生的数据会削弱未来几代模型的学习效率,最终引起所谓的“模型崩溃”。

几乎所有测试过的递归训练语言模型都表现出了这一问题。

例如,一项以中世纪建筑文本为原始输入的测试,到了第九代输出时,已变为一连串的野兔名称。

研究指出,使用前几代生成的数据集来训练AI,崩溃几乎是一个不可避免的结果。

因此,必须对数据进行严格的筛选。

同时,这也意味着依赖人类产生内容的AI模型或许能培养出更高效的AI系统。

总编辑评论:

对于AI而言,“模型崩溃”类似于癌症,有早、晚期之分。

早期时,接受生成数据的AI开始丢失部分正确原始数据;而在晚期,被“喂食”了生成数据的AI会输出完全不切合实际、与底层数据毫不相关的结果,如同本文案例所示。

更加令人担忧的是,一旦发生“模型崩溃”,错误几乎是无法纠正的,因为AI会变得极其顽固,持续强化错误的输出并认为是正确的。

这个问题应当受到所有关注生成式AI的人的警觉,因为它等同于在“污染”AI对真实世界的理解能力。

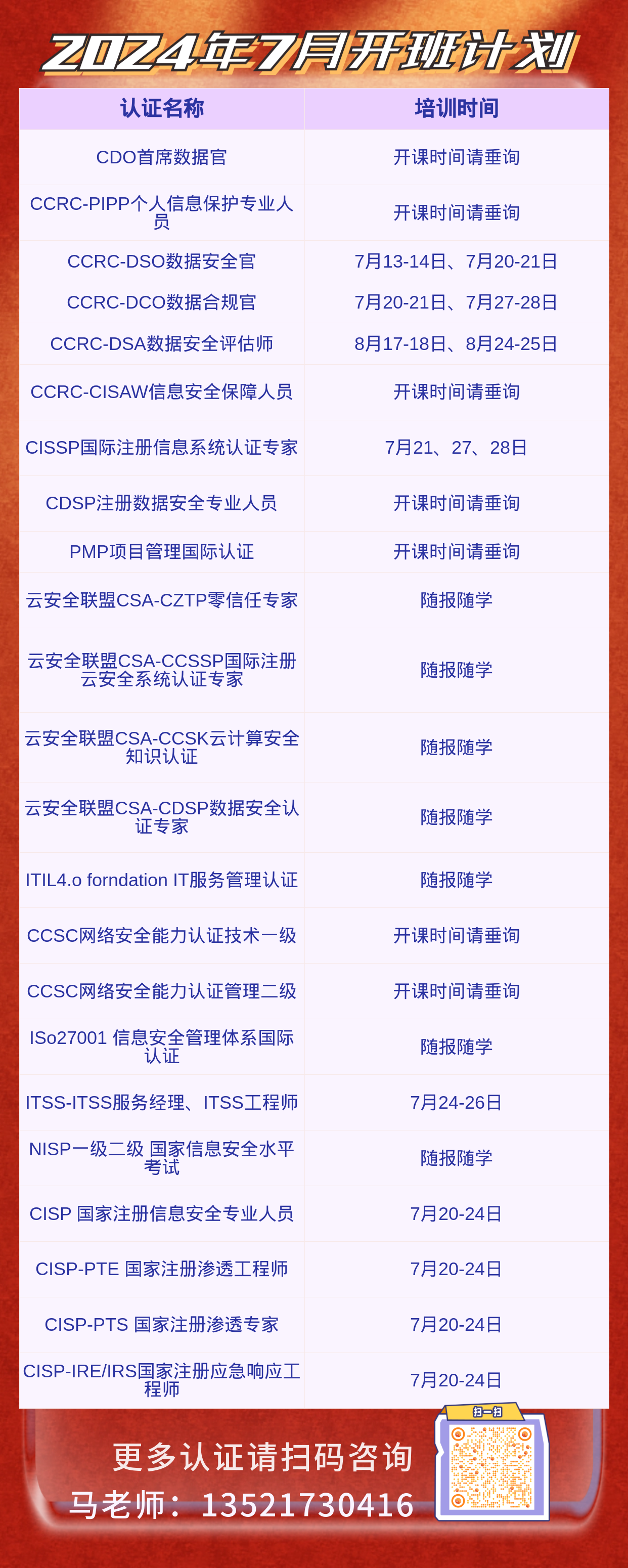

CCRC-DSO数据安全官,CCRC-DSA数据安全评估师,CCRC-DCO数据合规官,CDO首席数据官,,ITSS IT服务项目经理,IT服务项目工程师,认证办理北京青蓝智慧科技13521730416